每天,越来越多的人工智能应用进入市场,医疗设备成为创新医疗保健的完美目标。虽然联邦药品管理局已经批准了 130 多种此类工具,但一些专家表示需要重新评估审查过程。

这是一组斯坦福大学研究人员的说法,他们想知道监管机构和医生实际上对他们所宣传和批准的人工智能设备的准确性了解多少。根据发表在《自然》杂志上的研究,这些证据实际上可能揭示了人工智能技术的一些缺陷。研究人员分析了 2015 年至 2020 年间 FDA 批准用于他们研究的所有人工智能医疗设备。

他们发现人工智能设备的审批与药品的审批流程截然不同。

最大的问题在于用于训练 AI 算法的历史数据。在许多情况下,这意味着数据已经过时。许多算法在获得批准之前从未在临床环境中进行过实际测试,而且许多设备也仅在一两个地点进行了测试,限制了来自更多种族和人口统计学差异患者的数据的包含。

“令人惊讶的是,许多人工智能算法没有得到非常彻底的评估,”该研究的合著者詹姆斯·邹说,他是斯坦福大学生物医学数据科学助理教授,也是斯坦福大学的教员。以人为本的人工智能研究所(HAI)。

这也意味着 AI 设备并未在真实环境中针对活体患者进行评估。相反,预测和建议基于回顾性数据。

这种认识可能意味着人工智能医疗设备实际上可能无法捕捉医疗保健提供者如何在临床环境中实际使用这些工具。对于不同的人口统计数据也是如此。

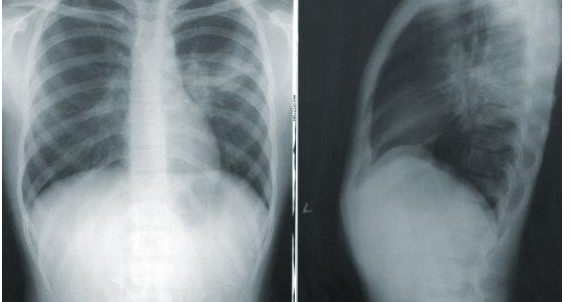

研究人员指出了一个深度学习模型,该模型分析胸部 X 光片中肺部塌陷的迹象,以证明他们的观点。虽然该模型对一组患者数据准确无误,但与其他两个患者数据站点相比,算法的准确度降低了 10%。患者的准确性也高于黑人患者。

“对于人工智能来说,众所周知的挑战是,一种算法可能适用于一个人群而不适用于另一个人群,”邹说。