人工智能(AI)已成为微观数据分析中不可或缺的组成部分。然而,在人工智能模型变得更好、更复杂的同时,计算能力和相关能源消耗也在不断增加。

因此,莱布尼茨分析科学研究所(ISAS)和北京大学的研究人员创建了一款免费压缩软件,使科学家能够更快地运行现有的生物成像人工智能模型,并且能耗显着降低。

研究人员在《自然方法》上发表的一篇文章中展示了他们的用户友好工具箱,称为EfficientBioAI。

现代显微镜技术可产生大量高分辨率图像,单个数据集可以包含数千个图像。科学家经常使用人工智能支持的软件来可靠地分析这些数据集。然而,随着人工智能模型变得更加复杂,图像的延迟(处理时间)可能会显着增加。

“高网络延迟,例如特别大的图像,会导致更高的计算能力,并最终增加能耗,”ISASAMBIOM(显微生物医学图像分析)初级研究小组组长陈建旭博士说。

一项众所周知的技术找到了新的应用

为了避免图像分析中的高延迟,特别是在计算能力有限的设备上,研究人员使用复杂的算法来压缩人工智能模型。这意味着它们减少了模型中的计算量,同时保持了相当的预测精度。

“模型压缩是一种广泛应用于数字图像处理(称为计算机视觉)和人工智能领域的技术,可以使模型变得更轻、更环保,”陈解释道。

研究人员结合各种策略来减少内存消耗、加速模型推理、模型的“思维过程”,从而节省能源。例如,剪枝用于从神经网络中删除多余的节点。

“这些技术在生物成像领域通常仍然未知。因此,我们希望开发一种即用且简单的解决方案,将它们应用于生物成像中的常见人工智能工具,”该论文的第一作者、博士周宇说。。AMBIOM的学生。

节能高达约81%

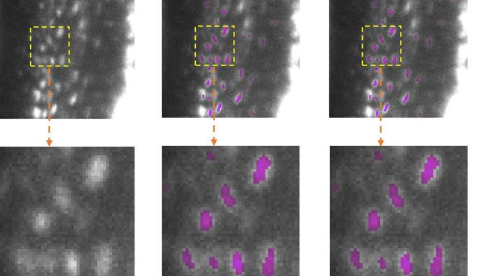

为了测试他们的新工具箱,陈领导的研究人员在几个现实应用程序上测试了他们的软件。对于不同的硬件和各种生物成像分析任务,压缩技术能够显着减少延迟并将能耗降低12.5%至80.6%。

“我们的测试表明,EfficientBioAI可以显着提高神经网络在生物成像中的效率,而不限制模型的准确性,”陈总结道。

他以常用的CellPose模型为例说明了节能效果:如果一千个用户使用工具箱压缩模型并将其应用到JumpTargetORF数据集(大约一百万个细胞显微镜图像),他们可以节省能源相当于汽车行驶约7,300英里(约11,750公里)的排放量。

无需特殊知识

作者热衷于让尽可能多的生物医学研究科学家能够使用EfficientBioAI。研究人员可以安装该软件并将其无缝集成到现有的PyTorch库(Python编程语言的开源程序库)中。

因此,对于一些广泛使用的模型,例如Cellpose,研究人员可以使用该软件,而无需对代码本身进行任何更改。为了支持特定的变更请求,该小组还提供了多个演示和教程。只需更改几行代码,该工具箱就可以应用于定制的人工智能模型。

关于高效生物人工智能

EfficientBioAI是一款即用型开源压缩软件,适用于生物成像领域的AI模型。即插即用工具箱保持简单的标准使用,但提供可定制的功能。其中包括可调节的压缩级别以及中央处理单元(CPU)和图形处理单元(GPU)之间的轻松切换。

研究人员正在不断开发该工具箱,并已致力于使其可用于除Linux(Ubuntu20.04、Debian10)和Windows10之外的MacOS。目前,该工具箱的重点是提高预训练的推理效率模型而不是提高训练阶段的效率。